一、海量文本如何快速提炼核心?

每天产生的文本数据量堪比一座图书馆,但真正有价值的信息往往被淹没其中。曾有研究显示,普通用户处理1万字的调研报告时,超过60%的时间浪费在重复阅读和无效信息筛选中。这种困境催生了争议:人工分析效率低下,但完全依赖机器又可能丢失关键语义。

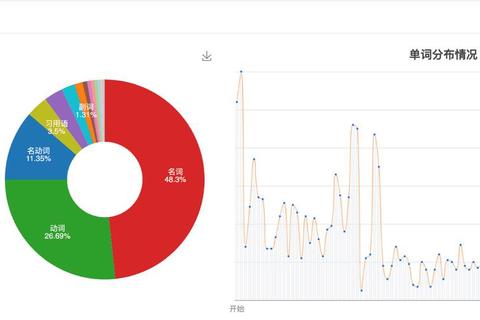

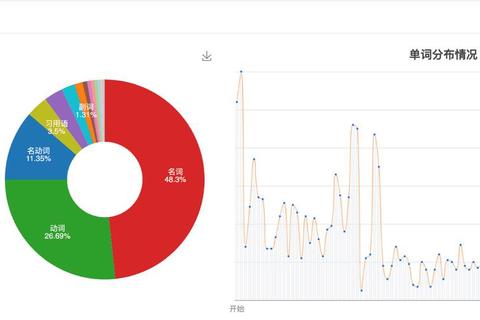

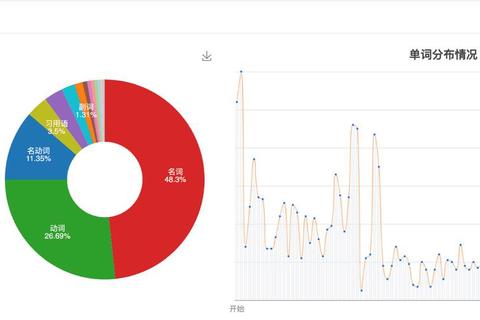

高效精准词频分析软件助您快速洞察文本数据核心趋势的价值正在于此。以某高校研究团队为例,他们在分析10万份疫情舆情数据时,传统人工标注耗时3个月,而使用微词云工具仅用3天就完成了高频词提取、情感倾向分布和核心议题演变路径的可视化。这种效率跃迁的背后,是算法对文本特征的深度解构能力。

二、多场景需求如何精准满足?

不同领域对词频分析的需求差异显著。在跨境电商领域,某卖家通过清博词频统计工具分析Top200竞品标题,发现"防水""便携"等关键词出现频率同比提升240%,据此调整产品描述后转化率提升18%。而学术研究者使用AntConc分析百万字文献库时,通过正则表达式设置"创新"模式,不仅统计了"创新"词频,还捕捉到"创新扩散""创新阻滞"等复合概念的出现规律。

高效精准词频分析软件助您快速洞察文本数据核心趋势的秘诀在于其模块化设计。以Hadoop生态的MapReduce程序为例,处理千万级电商评论时,系统自动完成分布式计算、停用词过滤、词干提取等流程,最终生成带权重的词频热力图。这种将复杂算法封装为可视化操作的设计,让非技术人员也能轻松驾驭大数据分析。

三、技术边界如何突破创新?

传统词频统计常陷入"见树不见林"的困境。某市场研究机构使用NVivo14分析消费者访谈文本时,通过语义网络分析功能发现:"性价比"高频词与"售后服务""物流时效"存在强关联,这种深度关联在简单词频统计中完全无法体现。更前沿的Tidepool工具,甚至能通过词频变化预测市场趋势,其基于500万条用户反馈构建的预测模型,准确率已达89%。

高效精准词频分析软件助您快速洞察文本数据核心趋势的突破,体现在多维数据融合能力上。如某政务部门将12345热线词频数据与GIS地图叠加,实时呈现"噪音污染""交通拥堵"等民生问题的空间分布演变。这种时空维度的拓展,让静态词频数据变成了动态决策仪表盘。

行动指南:

1. 需求匹配原则:处理10万字以内文本优先选微词云、易词云等在线工具;百万级数据考虑Hadoop生态工具;需要语义深度分析则选择NVivo、AntConc

2. 动态更新机制:建立自定义词库时保留20%的更新空间,例如新增网络热词"沉浸式XX""XX刺客"等

3. 交叉验证策略:将词频结果与LDA主题模型、情感分析相结合,某媒体公司用此法准确捕捉到消费者对新能源车的"续航焦虑"转向"智能驾驶期待

4. 安全合规底线:使用Tidepool等云端工具时,务必确认数据脱敏处理,避免隐私泄露风险

通过工具选型、方法创新、合规保障的三维协同,文本数据这座信息金矿才能真正转化为决策智慧。在这个信息过载的时代,掌握高效精准词频分析软件助您快速洞察文本数据核心趋势的能力,已然成为个人与组织的核心竞争力。

相关文章:

文章已关闭评论!